Une solution inspirée du cerveau pour éviter l’oubli catastrophique des IA

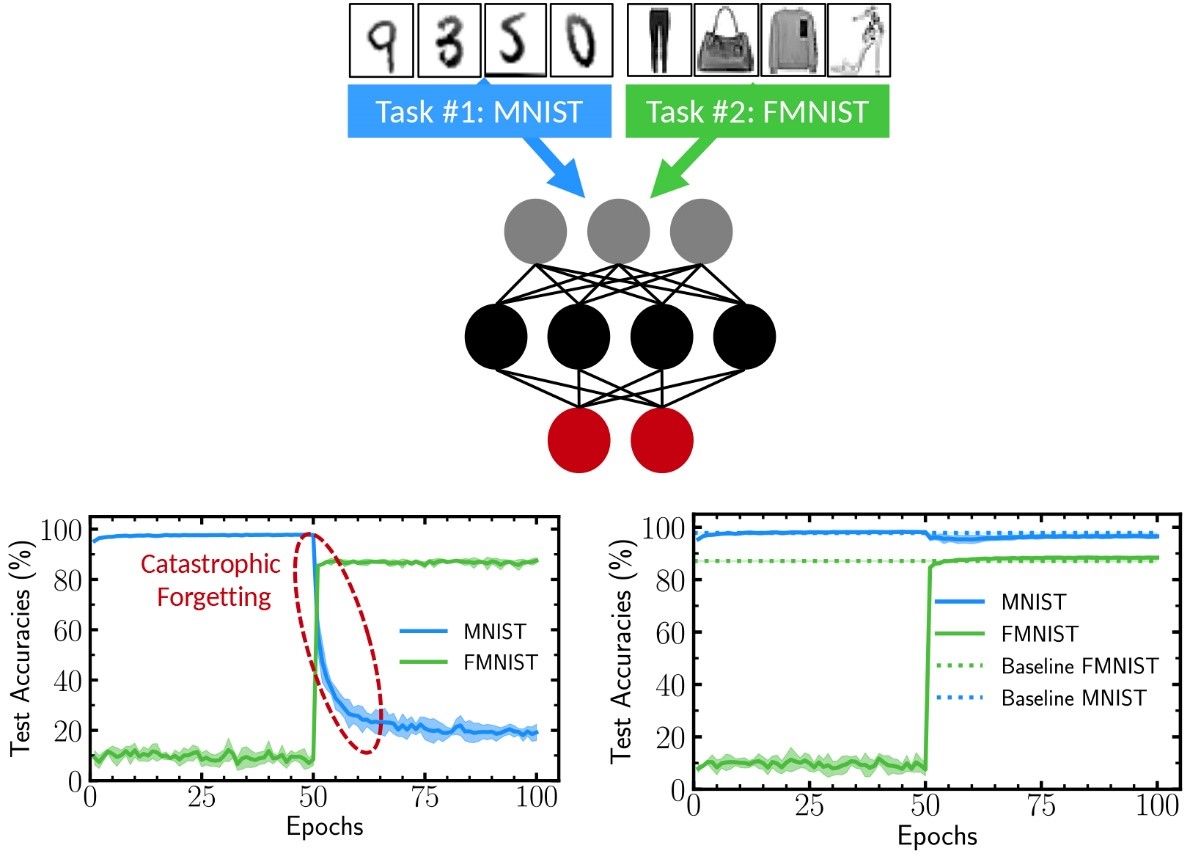

Alors que le cerveau sait quelles synapses préserver, les réseaux de neurones artificiels remploient arbitrairement certaines de leurs parties. La principale conséquence est qu’ils oublient souvent une tâche déjà apprise lorsqu’ils essayent d’en maîtriser une nouvelle. Des chercheurs du Centre de nanosciences et de nanotechnologies ont montré qu’un certain type de réseaux de neurones artificiels, dits binarisés, pouvaient se prémunir de ces oublis catastrophiques. Selon des travaux publiés dans Nature Communications, leur solution consiste à attribuer aux synapses artificielles un facteur d’importance pour la consolidation des souvenirs.

Si les réseaux de neurones artificiels continuent de nous étonner par leur capacité d’apprentissage, ils souffrent d’une limitation considérable : l’oubli catastrophique. Un réseau entraîné à une tâche voit son efficacité s’effondrer dès lors qu’on lui apprend une autre mission, y compris si elle est très proche de la première. Cet oubli est causé par les synapses artificielles, à qui les réseaux attribuent une valeur unique lors des phases d’apprentissage. Quand une nouvelle tâche est présentée, nombre de ces valeurs vont être remplacées et le réseau n’arrive alors plus à effectuer ce à quoi il avait précédemment été entraîné. Le cerveau, lui, dispose d’un mécanisme de consolidation grâce auquel il reconnaît les synapses porteuses des informations les plus importantes, et en modifie d’autres à la place. Des chercheurs du Centre de nanosciences et de nanotechnologies (C2N, CNRS/Univ. Paris Saclay) ont découvert que la consolidation était possible sur un certain type de réseaux de neurones artificiels : ceux qui sont dits binarisés. Ces derniers échappent ainsi à l’oubli catastrophique.

Développés depuis 2016, les réseaux de neurones artificiels binarisés fonctionnent avec une représentation mathématique binaire. Les valeurs que peuvent prendre les synapses sont réduites à 1 et -1, alors que les réseaux de neurones artificiels classiques utilisent toute la palette des nombres réels. Les réseaux de neurones binarisés étaient à l’origine étudiés pour leur faible consommation énergétique, mais les chercheurs du C2N ont découvert qu’ils pouvaient aussi garder une bien meilleure mémoire des apprentissages précédents. Les scientifiques pour cela ont utilisé, lors de l’apprentissage, une grandeur associée aux synapses binaires comme un facteur d’importance permettant de consolider les souvenirs. Le réseau est ainsi capable de modifier localement son niveau de plasticité, comme le fait le cerveau, et donc d’apprendre plusieurs tâches en réutilisant les synapses les moins cruciales. Les chercheurs indiquent que cela pourrait être particulièrement utile aux dispositifs médicaux, qui sont d’abord entraînés sur des données générales avant de s’adapter à la réalité du patient. Un apprentissage en deux étapes qui tend à perdre les bénéfices de la première phase. L’équipe du C2N travaille depuis à bloquer l’oubli catastrophique directement dans la partie électronique des réseaux de neurones artificiels, grâce à des nanocomposants magnétiques.

© Laborieux et al.

Références

Synaptic metaplasticity in binarized neural networks.

A. Laborieux, M. Ernoult, T. Hirtzlin & D. Querlioz.

Nature Communications, volume 12, Article number: 2549 (2021)

https://doi.org/10.1038/s41467-021-22768-y